L’intelligence artificielle franchit une nouvelle étape avec l’avènement des agents AI autonomes, ces entités capables de raisonner, planifier, dialoguer et même collaborer entre elles pour accomplir des tâches complexes. Autrefois réservée aux laboratoires de recherche avancée, cette technologie s’invite désormais dans les entreprises grâce à l’essor des frameworks open source, véritables boîtes à outils pour concevoir, orchestrer et superviser des agents intelligents.

Mais comment choisir le bon framework ?

Quels sont les outils les plus performants, les plus soutenus par la communauté, les mieux intégrés aux LLM comme GPT-4 ou Claude ?

Dans cet article, nous faisons le point sur les dix frameworks open source les plus pertinents en 2025, en analysant leurs spécificités, leurs cas d’usage, et leur niveau de maturité.

1. Qu'est-ce qu'un agent AI ?

Un agent AI est un programme logiciel autonome, capable de percevoir son environnement, de raisonner sur des données, de prendre des décisions et d’agir de manière proactive pour atteindre un objectif défini.

Alimenté par un LLM (Large Language Model) ou des moteurs logiques plus spécialisés, il agit comme une extension intelligente des systèmes métiers traditionnels. Là où un script automatisé exécute une suite d’instructions rigides, un agent AI sait contextualiser, s’adapter et évoluer.

C’est cette combinaison de compréhension du langage, de capacité décisionnelle et de collaboration dynamique qui le rend si puissant pour les entreprises.

Capacités clés d’un agent AI :

- Comprendre et interpréter le langage naturel : Grâce aux technologies de NLP, un agent AI peut lire, analyser et interpréter des demandes formulées en langage humain — par e-mail, chat, ou document — avec une finesse sémantique inégalée. Il ne se contente pas de mots-clés, il en saisit l’intention.

- Analyser des contextes métier complexes : Qu’il s’agisse de parcourir une base clients, de lire un contrat PDF ou de synthétiser un tableau Excel, l’agent est capable de structurer l’information, d’en extraire les signaux faibles et d’établir des liens pertinents pour une prise de décision plus rapide.

- Planifier des actions en autonomie : Un agent AI ne réagit pas uniquement aux événements. Il peut construire une séquence d’actions (workflow), enchaîner les étapes logiques, anticiper des conséquences, et s’ajuster selon les résultats obtenus — un véritable planificateur intelligent.

- Interagir avec l’écosystème numérique de l’entreprise : L’agent peut se connecter à des CRM, des ERP, des plateformes cloud ou des services web via API pour créer une synergie fluide entre l’IA et les outils métiers existants. Il devient ainsi une interface agissante entre l’humain, les données et les systèmes.

- Collaborer avec d’autres agents ou des équipes humaines : Dans un environnement multi-agent, chaque agent peut être spécialisé (rédacteur, analyste, validateur…) et interagir avec d’autres pour traiter une tâche complexe à plusieurs niveaux. Cela reproduit la logique d’une équipe projet dans un environnement virtuel.

- Apprendre du contexte et des retours utilisateurs : Avec une mémoire contextuelle intégrée, l’agent peut adapter son comportement à mesure qu’il évolue, en tenant compte des préférences, des données précédentes ou des feedbacks reçus.

Exemples concrets :

- Automatisation RH : L’agent prend en charge l’onboarding d’un nouveau salarié, en générant son contrat, en lui envoyant les documents nécessaires, et en notifiant les RH et le manager à chaque étape.

- Assistant projet intelligent : Il analyse les e-mails reçus d’un client, génère un compte-rendu de réunion, extrait les points d’alerte, assigne des tâches dans l’outil de gestion de projet, et propose une planification réaliste à l’équipe.

- Agent médical spécialisé : L’agent AI recueille les symptômes décrits en langage naturel, les croise avec une base de connaissances médicales, et propose une hypothèse diagnostique ou des examens complémentaires, à valider par un professionnel.

- Gestion intelligente du service client : Il trie les tickets d’assistance, reformule les demandes, propose des réponses personnalisées ou escalade les dossiers prioritaires. Il réduit les délais de traitement tout en améliorant la satisfaction client.

En 2025, les agents AI s’imposent comme des coéquipiers intelligents, capables de traiter de l’information, d’agir et d’interagir, bien au-delà d’un simple chatbot ou d’un automate traditionnel. Ils représentent une nouvelle couche d’intelligence opérationnelle pour les

2. Critères de sélection des frameworks

Avant d’établir notre comparatif, nous avons appliqué une grille d’analyse, combinant des critères techniques, fonctionnels et stratégiques.

L’objectif : ne retenir que les frameworks capables de répondre aux exigences réelles des entreprises, qu’il s’agisse de prototypage, de mise en production ou de déploiement à grande échelle.

Voici les cinq critères essentiels que nous avons privilégiés :

- Performance et scalabilité : Un bon framework doit permettre à un agent d’exécuter des tâches lourdes ou simultanées avec réactivité et stabilité. Cela inclut la gestion de multiples appels API, des traitements en arrière-plan, ou des interactions entre agents sans ralentissement. La scalabilité garantit également qu’un prototype puisse évoluer vers un usage intensif sans refonte.

- Licence open source : Transparence du code, absence de coûts cachés, possibilité d’audit ou de personnalisation… Une licence permissive (MIT, Apache 2.0) offre aux entreprises la liberté de modifier, étendre ou intégrer le framework sans contrainte juridique ou commerciale.

- Intégration native des LLM : Le moteur cognitif d’un agent repose souvent sur un LLM. Un bon framework doit proposer une intégration fluide avec des modèles comme GPT-4, Claude, LLaMA 3 ou Mistral, mais aussi permettre des bascules rapides entre fournisseurs (API OpenAI, Azure, Hugging Face…).

- Documentation et dynamique communautaire : Une documentation riche, à jour et didactique est indispensable pour l’adoption rapide d’un outil. À cela s’ajoute la vitalité du dépôt GitHub : fréquence des mises à jour, réactivité aux issues, volume de contributions, ou présence d’une communauté active (Discord, forums, etc.).

- Richesse des cas d’usage supportés : Un framework doit offrir plus qu’un simple chatbot. Nous avons recherché ceux capables de piloter des workflows, de gérer des rôles multiples, de conserver une mémoire longue, de déclencher des actions complexes ou encore de s’adapter à divers secteurs (RH, finance, marketing, IT, médical…).

Ces critères ont guidé la sélection des 10 frameworks présentés ci-dessous, chacun répondant à ces exigences avec une approche et une architecture qui lui est propre.

3. Présentation des 10 frameworks sélectionnés

LangChain est un framework modulaire open source pour développer des applications pilotées par LLM (Large Language Models).

Points clés :

- Langages : Python, JavaScript – Licence MIT

- Multi-agents : Oui, via LanGraph

- Intégration LLM : GPT-4, Claude, Mistral, LLaMA

- Écosystème : LanGraph, LangSmith

- Communauté GitHub : +100k stars, +17k forks

Cas d’usage :

Développement de chatbots, assistants autonomes, automatisation de processus documentaires, recherche contextuelle intelligente, agents pour l’analyse de données non structurées.

Lien utile : GitHub

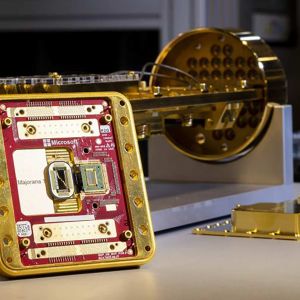

AutoGen est un framework avancé développé par Microsoft pour orchestrer des dialogues entre agents AI et humains. Il permet la construction de systèmes multi-agents autonomes, capables de collaborer autour de tâches complexes.

Points clés :

- Langages : Python – Licence MIT

- Multi-agents : Oui, avec architecture flexible

- Intégration LLM : GPT-4, Azure OpenAI, Claude

- Écosystème : AutoGenStudio, AutoGenUI (interfaces de démo)

- Communauté GitHub : +24k étoiles, soutenu par Microsoft

Cas d’usage :

Coordination de plusieurs agents pour la génération de rapports, planification de projets, ou simulation de workflows humains complexes.

Lien utile : GitHub

CrewAI permet d’assembler une équipe d’agents AI avec des rôles définis (chercheur, rédacteur, valideur…) pour accomplir des missions coopératives. L’interface de déclaration des rôles est simple et puissante.

Points clés :

- Langages : Python – Licence MIT

- Multi-agents : Oui, orchestrés par rôles

- Intégration LLM : GPT-4, Claude, Mistral, LLaMA

- Écosystème : Intégrable à LangChain et autres outils

- Communauté GitHub : Projet jeune mais actif

Cas d’usage :

Création de contenu automatisé, gestion collaborative de veille ou de rédaction, agents RH spécialisés par fonction.

Lien utile : GitHub

MetaGPT structure l’activité de plusieurs agents en simulant une équipe Agile (CEO, PM, Dev, QA…). Il intègre une logique de réunion, d’analyse de besoin et d’exécution séquentielle.

Points clés :

- Langages : Python – Licence MIT

- Multi-agents : Oui, structure hiérarchique Agile

- Intégration LLM : GPT-4, Claude

- Écosystème : Utilise FastAPI et Markdown comme standard

- Communauté GitHub : +35k étoiles

Cas d’usage :

Conception automatisée de logiciels, prototypage de fonctionnalités, planification produit.

Lien utile : GitHub

SuperAGI est une plateforme complète pour développer, tester et exécuter des agents AI autonomes. Elle propose une interface graphique, une mémoire persistante, et un marketplace d’outils intégrables.

Points clés :

- Langages : Python – Licence MIT

- Multi-agents : Oui, avec interface de monitoring

- Intégration LLM : OpenAI, Hugging Face, Azure, Claude

- Écosystème : GUI, mémoire vectorielle, projets multiples

- Communauté GitHub : +17k étoileCas d’usage :

Création d’assistants multi-tâches, agents de traitement de data, automatisation d’analyses croisées.

Lien utile : GitHub

n8n est un outil d’automatisation visuelle open source qui intègre désormais des agents AI à travers les LLMs. Il est particulièrement adapté aux non-développeurs souhaitant automatiser des workflows complexes avec de l’intelligence intégrée.

Points clés :

- Langages : JavaScript – Licence Fair-code

- Multi-agents : Oui, via intégration LLM

- Intégration LLM : OpenAI, Claude via connecteurs

- Écosystème : Plus de 300 intégrations natives (Airtable, Slack…)

- Communauté GitHub : +32k étoiles

Cas d’usage :

Support client automatisé, classification de tickets, workflows décisionnels avec logique conditionnelle.

Lien utile : GitHub

FlowiseAI est un framework low-code basé sur Node.js qui permet de créer visuellement des agents LLM et des assistants intelligents à l’aide de blocs configurables.

Points clés :

- Langages : TypeScript – Licence MIT

- Multi-agents : Oui

- Intégration LLM : GPT-4, Claude, Azure, Hugging Face

- Écosystème : Éditeur visuel, connecteurs API, base vectorielle

- Communauté GitHub : +13k étoiles

Cas d’usage :

Construction rapide de bots, génération automatisée de documents, assistants RH ou finance.

Lien utile : GitHub

LangGraph est une extension de LangChain qui permet de créer des workflows d’agents LLM sous forme de graphes, avec des états, des transitions, et une mémoire locale ou partagée. Points clés :

- Langages : Python – Licence MIT

- Multi-agents : Oui, en mode orchestré

- Intégration LLM : Toutes celles supportées par LangChain

- Écosystème : Fortement couplé à LangChain

- Communauté GitHub : Projet actif et en forte croissance

Cas d’usage :

Agents multi-étapes pour recherche, onboarding, diagnostic technique ou médical automatisé.

Lien utile : GitHub

Semantic Kernel est un SDK développé par Microsoft pour créer des agents IA « hybrides » : une logique de programmation classique enrichie par des fonctions IA comme la génération de texte, la recherche, ou la planification.

Points clés :

- Langages : Python, .NET, Java – Licence MIT

- Multi-agents : Oui, avec extensions personnalisables

- Intégration LLM : Azure OpenAI, Hugging Face, etc.

- Écosystème : Plugins, fonctions sémantiques, mémoire

- Communauté GitHub : +16k étoiles

Cas d’usage :

Création de copilotes IA, automatisation métier avec logique personnalisée, agents planificateurs multi-contraintes.

Lien utile : GitHub

Rasa est un framework NLP open source destiné à la création d’assistants conversationnels personnalisés et sécurisés, sans dépendance à des API tierces.

Points clés :

- Langages : Python – Licence Apache 2.0

- Multi-agents : Non (agent unique spécialisé)

- Intégration LLM : Possibilité d’interfacer via des connecteurs

- Écosystème : Rasa X pour entraînement conversationnel

- Communauté GitHub : +17k étoiles

Cas d’usage :

Chatbots internes, assistants clients, agents vocaux dans un cadre RGPD/privé.

Lien utile : GitHub

4. Quel framework d’agent AI choisir en 2025 ?

Le paysage des frameworks open source pour agents AI évolue à grande vitesse, porté par la montée en puissance des LLM et la demande croissante d’automatisation intelligente dans tous les secteurs. De LangChain à Rasa, en passant par AutoGen ou SuperAGI, chaque outil propose une approche singulière de la création d’agents autonomes, allant du low-code visuel à l’orchestration multi-agents en production.

Si votre besoin est modulaire, compatible avec plusieurs LLM et orienté performance, LangChain, LangGraph ou CrewAI sont des valeurs sûres.

- Pour une orchestration d’agents en équipe : pensez à MetaGPT ou AutoGen.

- Besoin d’une interface graphique complète et d’un suivi ? SuperAGI ou FlowiseAI feront l’affaire.

- Enfin, pour des usages conversationnels et respectueux de la vie privée, Rasa reste incontournable.

À retenir :

- Il n’existe pas de framework universel : chacun répond à des cas d’usage spécifiques.

- Le bon choix dépendra toujours de vos objectifs métiers, de votre stack technique et du niveau d’autonomie attendu de vos agents.

- L’idéal ? Tester plusieurs outils rapidement sur des prototypes ciblés avant de standardiser votre architecture.

Et pour mieux comprendre le lien entre LLM et agents AI, découvrez notre guide pratique :

LLM vs Agent AI : différences, applications, choisir