À l’heure où les tendances IT de 2025 soulignent l’importance croissante de l’automatisation, de l’intelligence artificielle et de l’analyse en temps réel, une autre réalité se dessine en arrière-plan : celle d’un web de plus en plus peuplé par des entités non humaines.

Derrière chaque clic, chaque visite ou chaque chargement de page, il devient crucial de se demander si l’interaction est réellement humaine… ou artificielle.

En 2024, selon le rapport annuel d’Imperva, près de la moitié du trafic mondial sur Internet provient désormais de bots, des programmes automatisés qui peuvent être soit bénéfiques (comme les crawlers de moteurs de recherche), soit nuisibles (comme les scrapers ou les robots de credential stuffing). Ce constat bouscule profondément les fondements de la stratégie digitale, notamment en matière d’analyse de données, de cybersécurité et d’optimisation de la performance des infrastructures.

1. Trafic Internet : chiffres-clés de 2024

Une répartition quasi-égale entre bots et humains

Les dernières études mettent en évidence un basculement majeur dans la nature du trafic Internet. En 2024, la répartition est la suivante :

- 49,6 % du trafic est généré par des bots :

- 32 % par des bots malveillants, tels que les scrapers, les spammeurs, les bots DDoS ou encore ceux utilisés pour du credential stuffing.

- 17,6 % par des bots dits « légitimes », comme ceux des moteurs de recherche (Googlebot), des outils d’analyse de performance ou encore des crawlers SEO.

- 50,4 % du trafic reste le fait d’utilisateurs humains.

Cette quasi-égalité cache un déséquilibre stratégique profond. Les actions humaines, authentiques et potentiellement engageantes, sont noyées dans un flot de signaux artificiels, ce qui complexifie considérablement l’analyse comportementale et la prise de décision fondée sur la donnée.

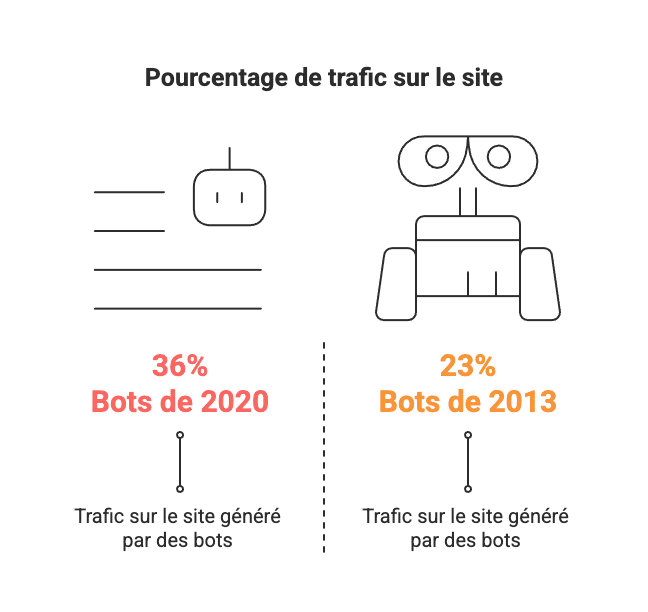

Une tendance structurellement à la hausse

Si l’on remonte dans le temps, la croissance du trafic généré par des bots est exponentielle. En 2013, les bots représentaient à peine 23 % du trafic. En 2020, on parlait de 36 %. L’essor des IA génératives, la facilité d’accès aux outils d’automatisation et l’économie souterraine de la fraude numérique ont contribué à rendre ces robots omniprésents.

Aujourd’hui, ignorer cette tendance revient à accepter une vision déformée de son audience, à prendre des décisions biaisées, et à exposer son infrastructure à des risques accrus.

2. Quels types de bots circulent sur le web ?

Comprendre les bots, c’est distinguer leurs intentions et usages. Il existe une large typologie, allant du plus utile au plus nuisible, en passant par une zone grise d’activités ambiguës.

Les bots utiles : des automatisations légitimes et bénéfiques

Tous les bots ne sont pas néfastes. Certains jouent un rôle essentiel dans l’écosystème numérique :

- Bots des moteurs de recherche : comme Googlebot ou Bingbot, ils explorent les sites web afin d’en indexer le contenu pour les résultats de recherche. Leur présence est non seulement normale, mais souhaitable pour le SEO.

- Bots de surveillance de performance : utilisés pour monitorer l’état de fonctionnement des sites, détecter les temps d’arrêt ou vérifier la disponibilité des pages.

- Chatbots conversationnels : intégrés dans les interfaces client (ex. Messenger, WhatsApp, Tidio), ils permettent une automatisation intelligente des interactions de premier niveau.

- Crawlers SEO : exploités par des outils comme Ahrefs, Semrush ou Screaming Frog, ces bots analysent la structure technique d’un site pour optimiser son référencement.

Les bots malveillants : la face sombre du trafic automatique

Derrière des intentions commerciales ou techniques se cachent aussi des activités plus problématiques :

- Scrapers de contenu : ils copient les textes, images et données d’un site sans autorisation pour les republier ailleurs (souvent dans une optique de black hat SEO ou de fraude).

- Spammeurs de formulaire : ils injectent automatiquement du contenu publicitaire ou des liens malveillants via des formulaires web mal protégés.

- Bots DDoS : ils lancent des attaques de déni de service distribué, en saturant les serveurs cibles jusqu’à leur mise hors ligne.

- Bots de credential stuffing : ils utilisent des listes d’identifiants volés pour tenter d’accéder à des comptes utilisateurs par force brute.

Une zone grise en expansion : scraping légal et agrégation commerciale

Certains bots n’ont pas d’intention directement malveillante, mais posent tout de même question sur le plan juridique ou éthique. C’est le cas :

- Des agrégateurs de données de prix, qui collectent automatiquement les tarifs sur plusieurs sites pour les afficher comparés.

- Des outils d’intelligence concurrentielle, qui scannent les fiches produits ou les avis clients pour en tirer des insights.

Ces pratiques, bien que parfois encadrées par les CGU, relèvent souvent d’un équilibre délicat entre veille, espionnage commercial et parasitisme numérique.

En résumé

La prolifération des bots dans le trafic Internet mondial n’est pas une anomalie passagère : c’est une nouvelle norme qui redéfinit les contours du numérique. Pour les entreprises, cela implique de repenser la manière dont elles mesurent leurs performances, sécurisent leurs plateformes, et interagissent avec leur audience. Un audit de trafic régulier, l’intégration d’outils de filtrage avancés et une vigilance constante face aux signaux faibles sont désormais incontournables.

Dans ce nouvel écosystème, les entreprises les plus résilientes seront celles capables de faire la différence entre l’activité authentique et les signaux parasites. Ce n’est qu’à cette condition qu’elles pourront reprendre la main sur leur stratégie digitale, affiner leurs décisions, et préserver la confiance numérique de leurs clients.

Le web de 2025 n’est pas celui que nous avons connu. Il est temps de poser les bonnes barrières… pour mieux tracer les bons chemins.

FAQ : Définitions techniques

Qu’est-ce que le credential stuffing ?

Le credential stuffing est une technique d’attaque automatisée qui consiste à utiliser des combinaisons d’identifiants (emails et mots de passe) volées sur un service pour tenter d’accéder à d’autres comptes utilisateurs. Cette méthode repose sur le fait que de nombreux internautes réutilisent les mêmes mots de passe sur plusieurs sites. Les bots peuvent tester des milliers d’identifiants à la seconde, rendant ce type d’attaque particulièrement redoutable pour les plateformes de services en ligne.

Que sont les crawlers SEO ?

Les crawlers SEO sont des bots utilisés pour analyser les sites web dans le but d’améliorer leur référencement naturel. Ils parcourent les pages d’un site, identifient les balises, les liens internes, la structure des contenus, les performances techniques et les éventuelles erreurs. Des outils comme Ahrefs, Semrush ou Screaming Frog exploitent ces crawlers pour fournir des audits détaillés aux spécialistes du SEO. Leur usage est légitime et bénéfique pour l’optimisation de la visibilité organique.

Que font les scrapers de contenus ?

Les scrapers de contenus sont des bots programmés pour copier automatiquement le contenu d’un site web : textes, images, tableaux, descriptions, etc. Le contenu volé est ensuite souvent publié sur d’autres sites, parfois pour des usages malveillants comme le plagiat, le duplicate content ou la génération de sites de spam. Cette pratique nuit fortement au référencement du site d’origine et viole généralement les conditions d’utilisation du contenu numérique.